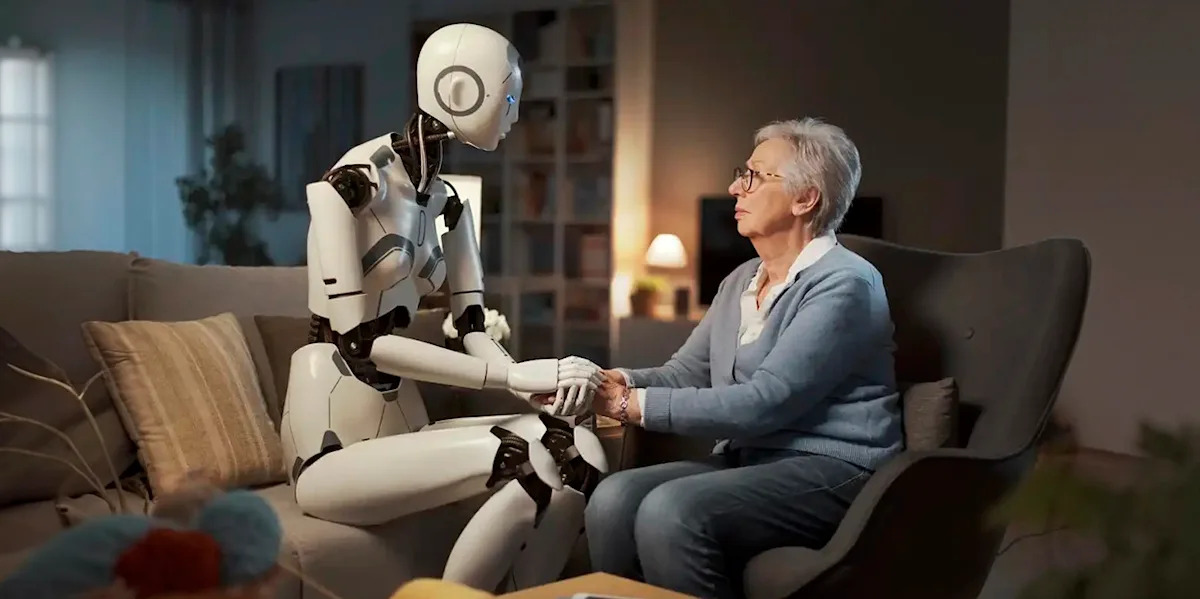

Actualmente presenciamos una escena que se repite con solución de continuidad, muchos de nosotros, en vez de acomodarnos en el diván o sentarnos frente a un terapeuta humano, abrimos una app, escribimos un par de frases entrecortadas y esperamos que un sistema de inteligencia artificial generativa (IAG) conteste con una mezcla de empatía sintética y razonamiento estadístico.

Lo sorprendente no es solo que la máquina responde rápido, sino que muchos usuarios de sistemas de IAG comienzan a sentir que “hablan” con alguien que los comprende, contiene y puede ayudarlos a gestionar altos niveles de ansïedad y dêpresïón. El fenómeno ya dejó de ser extravagancia tecnológica para convertirse en una práctica silenciosa, cotidiana y aparentemente tan efectiva como la terapia tradicional. Y es entonces cuando aparece una pregunta incómoda que atraviesa a psicólogos, tecnólogos, abogados y a cualquiera que haya llorado alguna vez en un consultorio.

A todo este nuevo universo de diván digital se suma un problema menos visible, pero igual de inquietante: la posibilidad de que el “terapeuta artificial” responda de manera sesgada. En efecto, los sistemas de IA aprenden de enormes volúmenes de texto producidos por humanos, con todos sus prejuicios incluidos. Esto puede traducirse en respuestas que refuercen estereotipos, malinterpreten situaciones sensibles o que, frente a emociones complejas, respondan con frases de autoayuda genérica, como si la angustia humana pudiera resolverse con motivación preformateada. Ese sesgo invisible es quizás el rïesgo más subestimado, porque no es evidente para quien busca ayuda y confía en que el terapeuta digital sabe lo que dice. Mientras tanto, la sociedad se acomoda como puede.

En Buenos Aires, Nueva York o San Pablo ya no sorprende escuchar a alguien manifestar que “habla de su crisis emocional con el chatbot”, con la misma naturalidad con la que antes se mencionaba al terapeuta del martes a las cinco de la tarde. La tecnología no vino a reemplazar lo humano, sino a recordarnos que lo humano es algo que todavía estamos aprendiendo a entender. Y lo humano, cuando de nuestra cabeza se trata, como de otras tantas cuestiones, nunca será reemplazable (o no debería serlo) por un sistema de IA.

Con información de: La Nación