El Accïdente Cerebrøvascular (ACV), es una de las principales amênâzas para la salud pública: segunda causa de müêrte y primera causa de dïscapacïdad en adultos y muchos supervivientes quedan con secueląs incapacitantes como dificultades del habla, problemas motores o cognitivos.

Una de estas consecuencias es la disartria, una forma de alteración del habla tras el daño neuronal, que limita gravëmente la capacidad de comunicación, aislando social y emocionalmente al paciente. Hasta ahora, las soluciones para estas secueląs han ido desde tërapias intensivas en logopedia hasta sistemas alternativos de comunicación que resultan lentos o poco naturales. Pero un nuevo estudio publicado en Nature Communications ha presentado una innovación que podría transformar la vida de pacientes con disartria post-ictus: un dispositivo portátil, no invasïvo, que se coloca alrededor del cuello (como un «collar inteligente») que detecta las vibraciones musculares sutiles y otros indicadores fisiológicos para reconstruir el habla en tiempo real.

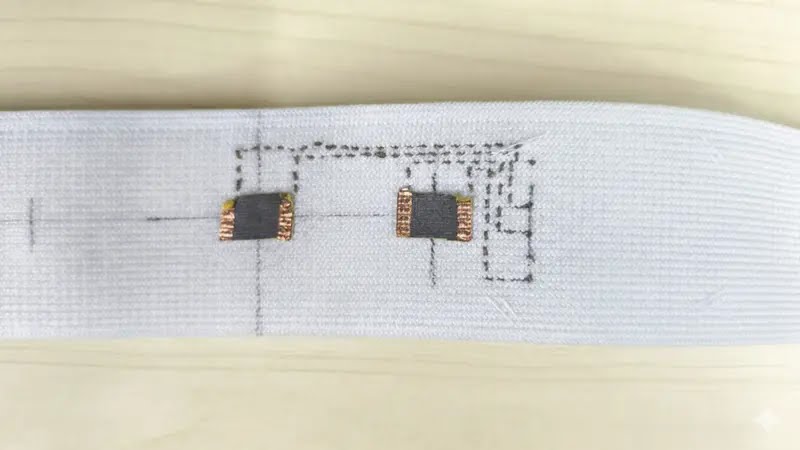

Este dispositivo, llamado Revoice, integra sensores ultrasensibles y algoritmos de inteligencia artificial que capturan señales del movimiento de los músculos de la garganta y del pulso carotídeo, y utilizan modelos avanzados de lenguaje para reconstruir frases completas casi en tiempo real. En pruebas con cinco pacientes con disartria, el sistema logró tasas de ërror muy bajas: 4,2% en palabras y 2,9% en frases completas. Esto, obviamente, mejoró significativamente la satisfacción de los usuarios al comunicarse. Y también la calidad de vida propia y de familiares.

A diferencia de otras tecnologías asistivas que requieren introducir letra por letra, seguimiento ocular o incluso implantes cerebrales, Revoice permite una comunicación fluida y natural, transformando movimientos silenciosos o apenas perceptibles en discurso coherente y expresivo. El dispositivo usa dos agentes de IA: uno decodifica las palabras a partir de fragmentos de movimiento silencioso de boca y cuello, y otro interpreta el estado emocional y el contexto (como la hora del día o el clima) para generar oraciones completas y expresivas.

Este avance no solo representa una nueva herramienta clínica para la rehabilitación del habla, sino también un paso hacia sistemas de comunicación asistida que respetan la naturalidad y expresividad del lenguaje humano. El uso de modelos de lenguaje integrados en tiempo real, combinados con señales fisiológicas reales, ofrece una vía inédita para traducir la intención de hablar en palabras audibles sin necesidad de voz física tradicional.

Con información de: La Vanguardia